Libro, ricerca e biblioteca: dal manoscritto all’intelligenza artificiale

Roma 15 maggio 2024, Sala conferenze, Dipartimento di Ingegneria, Via Vito Volterra 60 – come raggiungerci

Il libro ha attraversato metamorfosi profonde: dagli albori della scrittura, strumento di conservazione e condivisione della memoria, la sua fruizione si intreccia con i mezzi di produzione, la religione e l’arte. Questa complessa vicenda entra nella storia del luogo in cui il libro è custodito, la biblioteca, alterandone fisionomia e utilizzo, con una particolare accelerazione odierna legata agli strumenti informatici. Tra tradizione e innovazione tecnologica, un confronto sulle potenzialità dell’intelligenza artificiale e sugli aspetti connessi, da quelli giuridici a quelli tecnologici, da quelli cognitivi a quelli di intermediazione informativa. Con un ponte tra passato e futuro: manoscritti antichi decifrati da macchine intelligenti, automi che generano testi, e uno sguardo sul destino dell’autore.

E’ possibile seguire la diretta dell’evento.

Programma

Ore 14:30

Saluti istituzionali

Introduce e coordina: Prof. Andrea Guaccero, Università degli Studi Roma Tre

Interventi

Prof. Emanuele Conte, Università degli Studi Roma Tre

Le biblioteche, crocevia della vita universitaria

Le biblioteche universitarie nascono tra Duecento e Trecento; non nelle università, ma nei collegi: sono raccolte di libri e luoghi dove si studia insieme. Raccolgono i “multi libri” prodotti dal pensiero scolastico, ma sono anche il cuore dell’esperienza di vita condivisa dalla comunità. Durante l’età moderna, le grandi università affiancano a queste biblioteche collegiali anche delle biblioteche centrali, che rappresentano la realizzazione vera e concreta dell’idea moderna di “Universitas studiorum” (e non scholarium come nel Medioevo). Le scienze settoriali e disparate coltivate nei diversi Dipartimenti trovano un punto d’incontro nelle biblioteche centrali delle università più prestigiose del mondo.

Dalla fine del XX secolo, con un’accelerazione impressionante, le biblioteche universitarie e i sistemi bibliotecari hanno dovuto adattarsi alle novità introdotte dalla rivoluzione digitale. La centralizzazione è diventata indispensabile.

Dall’approccio alle nuove sfide delle biblioteche dipende buona parte del successo delle nuove università del XXI secolo: occorre ristrutturarle perché rinnovino il loro ruolo di centro catalizzatore dell’università in presenza come esperienza intellettuale; occorre adeguarle alla smaterializzazione dei contenuti; trasformarle in centri di documentazione perché le competenze professionali di cui dispongono siano applicate anche alla produzione e distribuzione, e non solo alla fruizione di opere scientifiche.

Per essere in condizione di affrontare queste sfide occorre recuperare lo spirito originario del SBA di Roma Tre che compie 30 anni. Nel 1994 fu progettato con straordinaria lungimiranza. Quella stessa lungimiranza va oggi rinnovata e rilanciata.

Dott.ssa Rosa Maiello, Direttrice Biblioteca di Ateneo dell’Università di Napoli Parthenope

L’Intelligenza artificiale all’università e in biblioteca nel quadro normativo europeo e internazionale

La produzione e il massiccio utilizzo di risorse e servizi digitali per la didattica, la ricerca e il patrimonio culturale ha comportato la necessità di sviluppare e aggiornare competenza avanzata sul mercato di riferimento e sulle fonti normative che lo regolano, tenendo conto che si tratta di un quadro soggetto a continue trasformazioni. Quali sono le prerogative, le opportunità, i rischi e i vincoli delle università e delle biblioteche come Cultural Heritage Institutions riguardo all’applicazione dell’Intelligenza artificiale? In questo contributo si proporrà una lettura sistematica delle fonti europee e nazionali applicabili per provare a fornire alcune risposte.

Prof. Alberto Gambino, Università Europea di Roma

Il casebook algoritmico

Il libro è valore, il valore della conoscenza nel tempo. Ricerca e conoscenza sono “tensione all’infinito” e implicano un sapere intellettuale profondo, affidato all’erudizione e alla trasmissione del sapere per apprendimento ed esperienza. La “casistica” è il sangue che circola nell’organismo del sapere.

La conoscenza mediata da un algoritmo ha ancora un valore concettuale di approfondimento o è una risposta tecnica al fabbisogno diffuso di problem solving? La tecnologia risulta abilitatrice di conoscenza ma amplifica fenomeni di “analfabetismo funzionale”. L’idealtypus della conoscenza mediata da un libro è stato un potente e imprescindibile fattore evolutivo per lo sviluppo sociale e culturale della comunità. La logica dell’algoritmo trova soluzioni “intelligenti” e immediatamente a portata: ma su quale base, su quali fonti? E con quale metodo di ricerca? Cosa trovano oggi nell’infosfera e di quali fonti si nutrono (esattamente “ingeriscono”) le IA?

La contendibilità dell’agorà virtuale retrocede gli interessi culturali nel girone degli interessi materiali, con obiettivi di massimizzazione economica che ordinano tali interessi. Una piena digitalizzazione del patrimonio librario italiano arricchirebbe di qualità l’infosfera così da andare oltre il modello “wikipedia”.

La “biblioteca” è esperienza e allenamento, dove fatica, fallimento e ripartenza significano crescita culturale e umana. Alla retorica dell’algoritmo, il modello ragionato di decifrazione di cataloghi e biblioteche offre segnali di rinascita e nuove applicazioni.

L’intelligenza artificiale, da strumento di analisi predittiva lineare e razionale che non considera il salto di paradigma che da sempre nella storia della conoscenza è foriero di progresso, assimila così un immortale modello educativo. Meccanismi di misurazione e intermediazione tecnologici possono ri-programmarsi al servizio della consapevolezza critica contenendo l’anelito commerciale della sostituzione integrale tra intelligenza artificiale e discernimento umano.

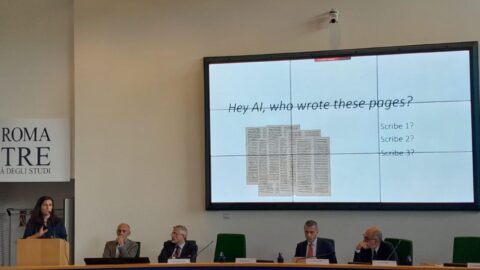

Prof.ssa Serena Ammirati (Università degli Studi Roma Tre), Prof. Marco Maiorino (Archivio Apostolico Vaticano), Prof. Paolo Merialdo (Università degli Studi Roma Tre)

In Codice Ratio: Machine Learning meets Digital Humanities

Il progetto In Codice Ratio rappresenta una interessante esperienza di ricerca interdisciplinare nella quale sono state progettate ed applicate soluzioni innovative di Machine Learning per risolvere problemi di Digital Humanities. Particolare attenzione verrà posta nella presentazione del caso di studio sui registri papali dell’archivio apostolico vaticano.

[Visita all’esposizione di Numero Cromatico]

Prof. Francesco Agrusti, Università degli Studi Roma Tre

Oltre Google: come l’Intelligenza Artificiale sta rivoluzionando la ricerca bibliografica e di informazioni

Dopo l’era di AltaVista e Yahoo!, con l’avvento dell’algoritmo PageRank, Alphabet è diventata la società che più spesso è stata confusa con la totalità di Internet. Dal neologismo ‘googlare’ alle multe fino a 2,4 mld di euro per concorrenza sleale e monopolio, Google è diventato sinonimo di motore di ricerca. Oggi con l’avvento dei Large Language Model, individuare le giuste parole chiave, sapersi districare tra i diversi risultati, essere efficienti ed efficaci nella ricerca in rete diventerà un ricordo lontano, o forse no? Dopo i primi scivoloni dei “vecchi” modelli, ci si sta timidamente affacciando ad una nuova era dei motori di ricerca che sfrutta l’interfaccia dei chatbot basati sui vari LLM per aiutarci nella ricerca di informazioni, anche bibliografiche. Ma le allucinazioni sono sempre dietro l’angolo e abbiamo tanti problemi dai pregiudizi degli algoritmi, alla privacy, passando per l’autorialità. Quali sono gli strumenti, ad oggi disponibili, per poter effettuare ricerche online e bibliografiche? E quali quelli per scrivere articoli scientifici? Che cosa ci aspetta in prossimo futuro?

Prof. Gino Roncaglia, Università degli Studi Roma Tre

L’IA generativa in editoria

Le conseguenze dell’introduzione dell’IA generativa in campo editoriale sono potenzialmente assai notevoli. L’intervento si soffermerà in particolare su tre temi: l’accessibilità, la generazione automatica dei metadati, la personalizzazione dei contenuti.

Dott. Nicola Zamperini, giornalista professionista

La sterminata meta-biblioteca digitale dell’intelligenza artificiale

L’intervento affronterà il ruolo e il destino del linguaggio nell’era dell’intelligenza artificiale generativa, esplorando come miliardi di parole, attraverso set di dati che raccolgono materiali di ogni genere, dall’intera Wikipedia ad articoli scientifici, a migliaia di romanzi, siano fondamentali per l’addestramento di questa tecnologia. E come, ogni giorno, altre milioni di parole vengano scambiate e valutate in un’asta digitale continua da parte del motore di ricerca. Queste collezioni di testi sono come biblioteche sterminate che nessun umano potrà mai leggere per intero, e che non servono alla trasmissione del sapere ma alla costruzione della capacità di linguaggio delle macchine. Il contributo esplorerà a cosa servono i testi in questo ambito, riflettendo su come vengano trasformati e assorbiti dalle reti neurali e come le macchine ne producano ormai senza limiti. La maggior parte dei contenuti presenti in rete non verrano più scritti da esseri umani ma dalle macchine e questo orizzonte è prossimo. E allora che tipo di parole sono le parole così utilizzate dall’intelligenza artificiale generativa? Che ruolo avranno nella nostra esistenza?

Prof. Dionigi Mattia Gagliardi, Accademia di Belle Arti di Roma; fondatore di Numero Cromatico

Autorialità e intelligenze artificiali nel panorama artistico contemporaneo

Nell’attuale contesto, in cui le IA sono sempre più presenti nelle nostre vite, il ruolo dell’autorialità ritorna ad essere un tema di grande interesse per la ricerca artistica. L’intervento, attraverso un approccio interdisciplinare, affronterà (a) il ruolo dell’autorialità e dell’artista nella storia dell’arte e (b) il pregiudizio sull’utilizzo di intelligenze artificiali nella creazione di opere d’arte. Si cercherà di sfatare alcuni miti sulla creazione artistica e aprire una riflessione sul futuro delle intelligenze artificiali in ambito artistico.

Prof. Mario De Caro, Università degli Studi Roma Tre

Intelligenza artificiale, coscienza e comprensione

I Large Language Models hanno dato nuovo vigore alle discussioni sulle prerogative dell’Intelligenza artificiale e, più in particolare, su un suo aspetto particolare ossia la possibilità che ai sistemi di AI si possa attribuire la capacità di comprendere il linguaggio umano. Queste discussioni, però, sono spesso viziate da un errore concettuale di base di cui mi occuperò brevemente nel mio talk.

Locandina evento